Data Lake Was ist ein Data Lake?

Ein Data Lake ist ein Daten-Repository, in dem Daten ohne Änderungen in ihrer ursprünglichen Form gespeichert werden. Anders als Data Warehouses oder Silos nutzen Data Lakes eine flache Architektur mit Objektspeicher für die Metadaten der Dateien. Dies ist besonders hilfreich, wenn es Teil einer größeren Datamanagement-Plattform ist und sich gut in bestehende Daten und Tools integrieren lässt, um leistungsstärkere Analysen durchzuführen. Ziel ist es, Erkenntnisse zu gewinnen und Trends zu ermitteln, während Sicherheit, Skalierbarkeit und Flexibilität gewährleistet bleiben.

Inhaltsverzeichnis

Data Lakes erklärt

Ein Data Lake wird verwendet, um eine große Menge Daten in ihrem nativen Rohformat an einem zentralen Ort zu speichern (üblicherweise in der Cloud). Durch kostengünstigen Objektspeicher, offene Formate und Cloud-Skalierbarkeit können zahlreiche Anwendungen von der großen Datenmenge in einem Data Lake profitieren.

- Alle Arten qualitativer Daten, einschließlich unstrukturierter (sog. Big Data) und semistrukturierter Daten können gespeichert werden. Ein entscheidendes Kriterium für heutige Anwendungsfälle wie maschinelles Lernen und erweiterte Analysen.

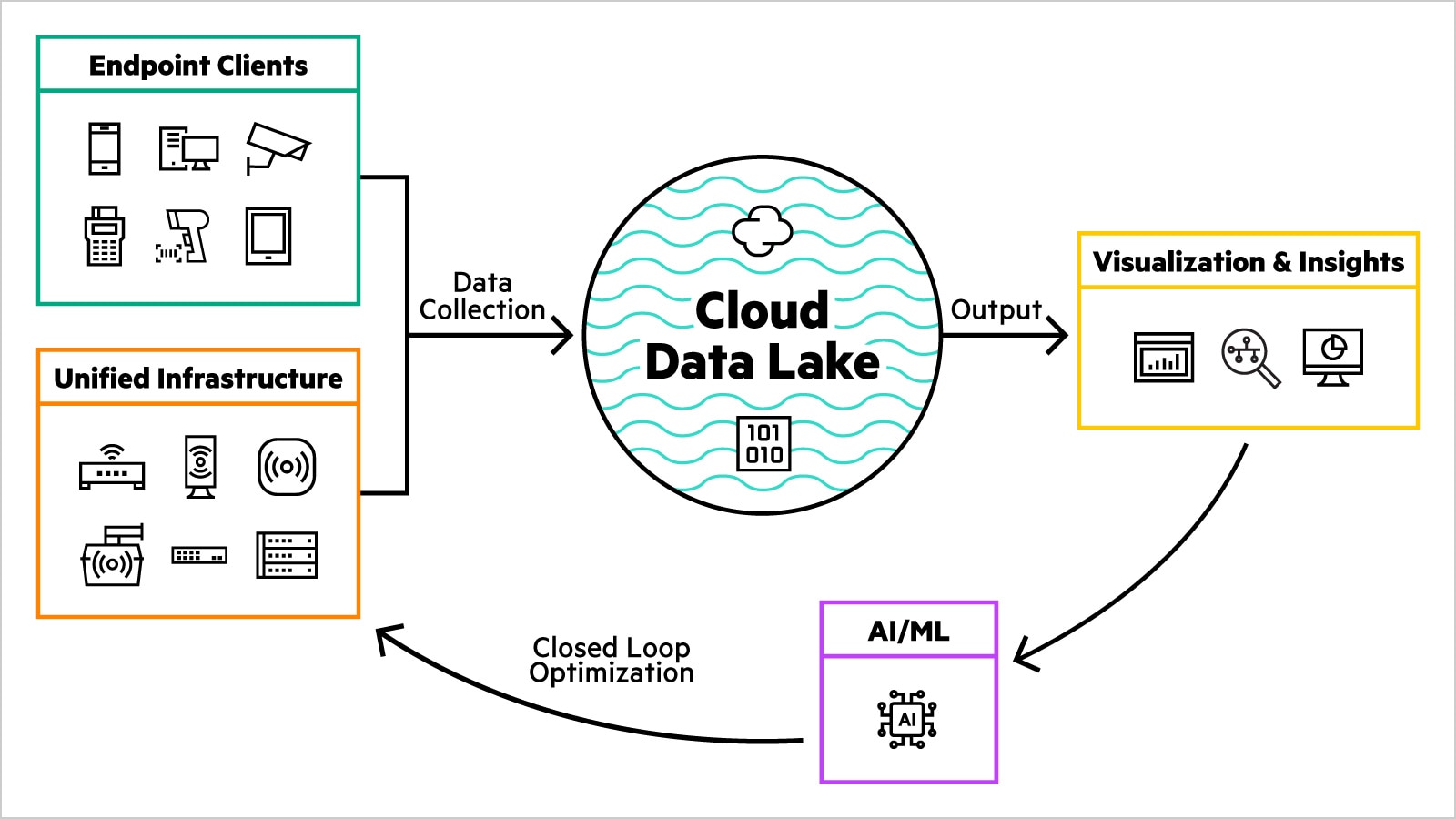

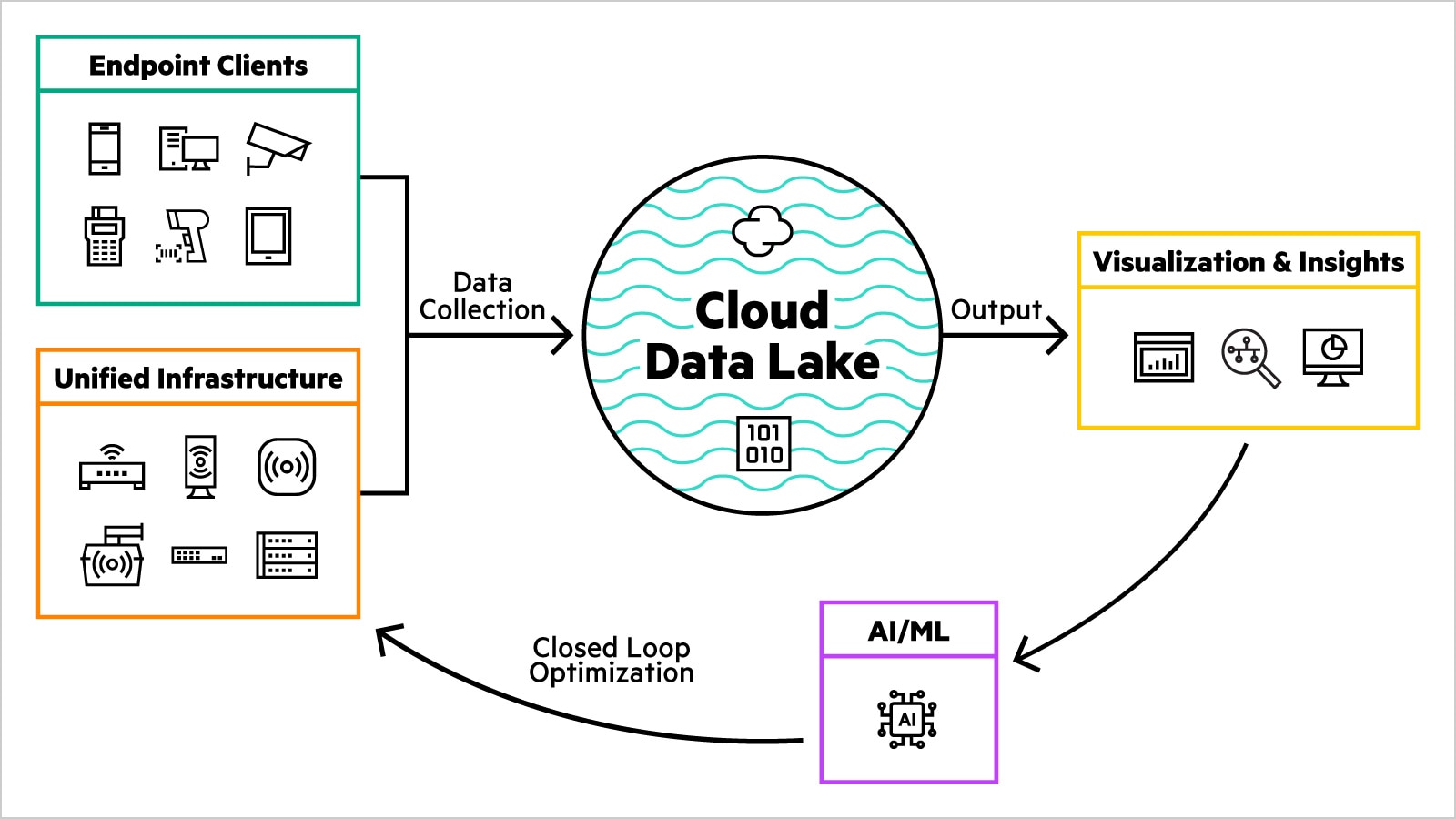

- Stellen Sie sich im Netzwerkbereich vor, dass Infrastruktur- und Endgeräte-Telemetrie als Beschreibungen oder Klassifizierungen genutzt werden, um KI-/ML-Modelle und -Algorithmen zu speisen und Baselines sowie Anomalien zu erkennen.

- Kundenseitig speisen die Infrastruktur- und Endgeräte-Clients den Data Lake. Der Netzwerkanbieter pflegt den Data Lake, um KI-basierte Tools zu bieten, die die IT-Abteilung bei einem effizienteren Betrieb des Netzwerks unterstützen.

Warum entscheiden Unternehmen sich für Data Lakes?

Data Lakes bieten Unternehmen die Möglichkeit, unformatierte Rohdaten in strukturierte Daten umzuwandeln, die für SQL-basierte Analysen, Data Science und maschinelles Lernen verwendet werden können, jedoch mit geringerer Latenz. Alle Datentypen können einfacher erfasst und unbegrenzt gespeichert werden, einschließlich Streaming-Images, Videos, Binärdateien und mehr. Da der Data Lake für zahlreiche Dateitypen geeignet ist und einen sicheren Speicherort für neue Dateien darstellt, kann er einfacher auf einem aktuellen Stand gehalten werden.

Durch diese Flexibilität ermöglichen Data Lakes Benutzern mit unterschiedlichen Kenntnissen, regionalen Standorten und Sprachen das Ausführen der von ihnen benötigten Aufgaben. Im Gegensatz zu den durch Data Lakes ersetzten Data Warehouses und Silos bieten Data Lakes eine deutliche Flexibilität für Big Data- und ML-Anwendungen.

Vorteile eines Data Lakes

Data Lake-Kunden profitieren unter anderem von folgenden Vorteilen:

- Dynamische Basisdaten zur Netzwerkleistung ihres Standorts ohne manuelle SLE-Definition.

- Vergleiche, die hervorheben, wo ähnliche Standorte vor Problemen stehen, die durch ihre eigenen Daten verursacht werden.

- Optimierungstipps basierend auf den Leistungsdaten eines ähnlichen Kundenstandorts mit ähnlichem Verhalten.

- Kontinuierliche Trainingswiederholungen für KI/ML, wenn neue Technologien, Infrastrukturen und Endgeräte eingesetzt werden.

Data Lake vs. Data Warehouse

Wenngleich sowohl Data Lakes als auch Warehouses genutzt werden können, um große Datenmengen zu speichern, bestehen einige wesentliche Unterschiede in der Art des Datenzugriffs oder der Datennutzung. Data Lakes speichern unformatierte Daten praktisch jeden Dateityps. Alternativ speichert ein Data Warehouse Daten, die bereits für einen bestimmten Zweck strukturiert und gefiltert wurden.

Dank ihres offenen Formats benötigen Data Lakes keinen bestimmten Dateityp und die Benutzer begeben sich nicht in eine Anbieterabhängigkeit. Ein Vorteil von Data Lakes im Vergleich zu Silos oder Warehouses und einer strukturierteren Umgebung ist die Möglichkeit, jeden beliebigen Daten- oder Dateityp zu speichern. Ein weiterer Vorteil besteht darin, dass der Zweck zum Zeitpunkt der Einrichtung noch nicht bestimmt werden muss, anders als bei einem Data Warehouse, das als Repository für gefilterte Daten erstellt wird, die bereits zu einem bestimmten Zweck verarbeitet wurden.

Ein zentraler Data Lake ist Silos und Warehouses vorzuziehen, da er Probleme wie Datenduplikate, redundante Sicherheitsrichtlinien und Schwierigkeiten bei der Zusammenarbeit zwischen mehreren Benutzern beseitigt. Für den nachgelagerten Benutzer erscheint ein Data Lake wie ein einzelner Ort, um nach mehreren Datenquellen zu suchen oder diese zu interpolieren.

Data Lakes sind aufgrund ihrer Skalierbarkeit sowie ihrer Fähigkeit, Objektspeicher zu nutzen, ebenfalls vergleichsweise langlebig und wirtschaftlich. Und da erweiterte Analysen und maschinelles Lernen mit unstrukturierten Daten für viele heutige Unternehmen zunehmend Priorität genießen, sind Data Lakes dank der Fähigkeit zur Aufnahme von Rohdaten in strukturierten, semistrukturierten und unstrukturierten Formaten zunehmend als Datenspeicher gefragt.

Was sind Data Lake-Plattformen?

Nahezu alle großen Cloud-Service-Anbieter bieten moderne Data Lake-Lösungen. On-Premises Rechenzentren nutzen weiterhin das Hadoop File System (HDFS) als Quasi-Standard. Da die Unternehmen weiterhin verstärkt zu Cloud-Umgebungen wechseln, stehen Data Scientists, Ingenieuren und IT-Experten zahlreiche Optionen zur Verfügung, um von den erweiterten Möglichkeiten zu profitieren, die eine Verschiebung ihres Datenspeichers in eine Cloud-basierte Data Lake-Umgebung bietet.

Data Lakes sind besonders bei der Arbeit mit Streaming-Daten hilfreich, z. B. JSON. Die drei typischsten Anwendungsfälle sind Geschäftsanalysen oder Business Intelligence, Data Science mit Schwerpunkt auf maschinellem Lernen und Datenbereitstellung – Hochleistungsanwendungen, die von Echtzeitdaten abhängig sind.

Alle großen Cloud-Service-Anbieter, von Amazon Web Services (AWS) über Microsoft Azure bis hin zu Google BigQuery, bieten die für Cloud-basierte Data Lakes erforderlichen Datenspeicher und Services an. Welches Maß an Integration ein Unternehmen auch anstrebt – von einfachen Sicherungen bis hin zur vollständigen Integration –stehen zahlreiche Optionen zur Verfügung.

Wie werden Data Lakes heute genutzt?

Anders als noch vor zwei oder drei Jahrzehnten basieren die meisten Geschäftsentscheidungen nicht mehr auf in Warehouses gespeicherten Transaktionsdaten. Der grundlegende Wandel von einem strukturierten Data Warehouse zu einer flexiblen modernen Data Lake-Struktur ist die Reaktion auf sich verändernde Anforderungen und Möglichkeiten moderner Big Data- und Data Science-Anwendungen.

Obwohl weiterhin fast täglich neue Anwendungen hinzukommen, konzentrieren sich einige der typischeren Anwendungen für den modernen Data Lake auf die schnelle Erfassung und Analyse neuer Daten. Beispielsweise kann ein Data Lake die Kundendaten einer CRM-Plattform mit Social Media-Analysen oder einer Marketing-Plattform kombinieren, die eine Kunden-Kaufhistorie beinhaltet. Durch eine solche Kombination kann ein Unternehmen potenzielle Gewinnmöglichkeiten oder die Ursachen für Kundenabwanderung besser verstehen.

In ähnlicher Weise ermöglicht ein Data Lake Forschungs- und Entwicklungsteams den Test von Hypothesen und die Bewertung der Ergebnisse. Mit stetig zunehmenden Möglichkeiten der Datenerfassung in Echtzeit beschleunigt ein Data Lake die Speicher- oder Analyseverfahren, gestaltet sie intuitiver und erhöht die Zugänglichkeit für Ingenieure.

HPE und Data Lakes

Heute Unternehmen nutzen Big Data, um ihre größten Herausforderungen zu bewältigen. Hadoop war erfolgreich, um eine Wertschöpfung aus unstrukturierten Daten zu erzielen, doch nun suchen Unternehmen neuere und bessere Möglichkeiten, dies zu bewerkstelligen.

Heutige Unternehmen investieren in erheblichem Umfang in Analysen – von Systemen über Data Scientists bis hin zum IT-Personal – um ihr lokales Hadoop-basiertes Data Management zu implementieren, zu betreiben und zu pflegen. Wie bei jeder Datenumgebung kann sich der Kapazitätsbedarf exponentiell verändern.

GreenLake bietet Unternehmen eine vollständig skalierbare, Cloud-basierte Lösung, die ihre Hadoop-Nutzung grundlegend vereinfacht, Komplexitäten und Kosten beseitigt und stattdessen die Konzentration auf die Gewinnung von Erkenntnissen aus Daten ermöglicht. GreenLake bietet eine vollständige End-to-End-Lösung mit Hardware, Software und HPE Services.

GreenLake maximiert das Potenzial Ihrer Daten, indem die Vorteile des lokalen HDFS Data Lakes und zugleich die Cloud-basierten Vorteile und Erkenntnisse vollständig genutzt werden.